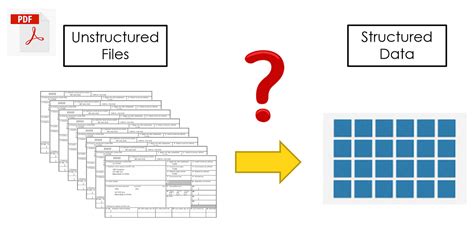

在這個數字時代,PDF檔案已成為資訊傳遞的重要工具之一。無論是研究報告、技術文件還是電子書,PDF都以其便捷性和廣泛的兼容性受到人們的喜愛。但問題是,如何有效地從互聯網上抓取這些PDF文件,並將其下載到本地呢?別擔心,今天我們將深入探討如何用Python來實現這一目標。準備好您的咖啡,讓我們一起進入Python的世界吧!

使用Python抓取PDF內容的必備工具

為了能夠成功抓取和下載PDF文件,我們需要一些Python的強大庫。這些工具將使我們的工作變得更加輕鬆。以下是我們在此過程中將使用的一些關鍵庫:

- requests:這個庫是Python中最受歡迎的HTTP庫之一,用於發送HTTP請求,特別適合用來抓取網頁內容。

- io:此庫提供了Python的核心I/O功能,可以用來處理文件的讀寫操作。

- PDFMiner、PyPDF2、PDFQuery 和 PyMuPDF:這些是一些專門用於從PDF中提取數據的庫。

- BeautifulSoup:雖然主要用於解析HTML,但在提取PDF鏈接的過程中會派上用場。

開始抓取!用requests庫下載PDF

首先,我們需要從網頁上獲取PDF文件的URL。這可以通過requests庫發送HTTP GET請求來實現。以下是如何使用requests庫來抓取PDF文件的一個簡單範例:

import requests

pdf_url = "http://example.com/sample.pdf"

response = requests.get(pdf_url)

with open("sample.pdf", "wb") as pdf_file:

pdf_file.write(response.content)

這段程式碼的工作原理簡單明瞭:首先,我們定義PDF文件的URL,然後使用requests.get()發送GET請求來獲取文件內容。最後,我們將內容寫入一個新的PDF文件中,並保存在本地。

使用io庫處理PDF文件

在確保PDF文件已成功下載後,我們需要使用io庫來進一步處理文件。io庫允許我們以流的形式處理文件內容,這對於大文件特別有用。以下是如何使用io庫來讀取PDF文件:

import io

with open("sample.pdf", "rb") as file:

pdf_content = io.BytesIO(file.read())

這段程式碼的作用是將PDF文件讀入一個內存流中,這樣我們便可以更方便地進行處理。

PDF內容提取的秘密武器

下載PDF僅僅是第一步,接下來我們需要從中提取有價值的信息。這就需要用到一些專門的PDF處理庫。以下是幾個常用的庫及其功能:

- PDFMiner:非常強大的PDF解析工具,可以提取文本、圖像等內容。

- PyPDF2:輕量但功能強大的工具,適合進行基本的PDF處理。

- PDFQuery:結合了PDFMiner和XPath的功能,適合從結構化的PDF中提取信息。

- PyMuPDF:快速高效的PDF處理工具,支持多種格式轉換。

這些庫各有千秋,選擇適合你的工具將使你的工作事半功倍。

用PDFQuery從多個PDF中提取數據

假設我們需要從多個PDF文件中提取特定數據,PDFQuery是一個不錯的選擇。以下是如何使用PDFQuery從多個PDF中提取數據:

from pdfquery import PDFQuery

pdf = PDFQuery("sample.pdf")

pdf.load()

# 找出特定文本

text = pdf.pq('LTTextLineHorizontal:contains("特定文本")').text()

print(text)

這段程式碼展示了如何使用PDFQuery來查找並提取PDF文件中的特定文本。PDFQuery允許我們使用強大的XPath查詢來定位和提取PDF中的元素。

使用BeautifulSoup提取PDF鏈接

在抓取PDF之前,我們首先需要從網頁中提取出PDF文件的鏈接。這是BeautifulSoup派上用場的地方。以下是一個示範,展示如何使用BeautifulSoup來提取PDF鏈接:

from bs4 import BeautifulSoup

import requests

url = "http://example.com"

response = requests.get(url)

soup = BeautifulSoup(response.text, "html.parser")

# 找出所有PDF鏈接

pdf_links = [a['href'] for a in soup.find_all('a', href=True) if a['href'].endswith('.pdf')]

print(pdf_links)

此示範顯示如何從網頁上擷取所有指向PDF文件的鏈接。BeautifulSoup是解析HTML和XML文件的利器,讓我們能夠輕鬆地從中提取需要的數據。

懶人專用工具Scrapy

如果你覺得手動抓取PDF文件過於繁瑣,那麼Scrapy這個強大的爬蟲框架可能會是你的好幫手。Scrapy能夠自動化地從網頁中抓取數據,以下是如何使用Scrapy來抓取PDF文件:

- 進入Scrapy Shell

- 爬取PDF所在的網頁URL

- 使用XPath提取PDF的鏈接

- 發送fetch請求獲取PDF內容並保存

這些步驟將大大簡化抓取流程,讓你能夠專注於數據分析的部分。

常見問題

如何確保下載的PDF文件是完整和正確的?

在下載PDF時,我們可以通過檢查HTTP響應的狀態碼來確保文件已正確下載。例如,狀態碼200表示請求成功。此外,可以使用文件大小或校驗和來驗證文件的完整性。

是否有其他庫可以用來處理PDF文件?

是的,除了PDFMiner、PyPDF2、PDFQuery 和 PyMuPDF,還有許多其他庫如Slate和Pdfplumber,它們各自有不同的優勢和適用場景。

如何處理含有圖像的PDF文件?

處理含有圖像的PDF文件通常需要用到專門的圖像處理庫,如Pillow或OpenCV,這些庫可以幫助提取和轉換PDF中的圖像內容。

能否自動化整個抓取和下載過程?

絕對可以!使用Scrapy等爬蟲框架,你可以編寫腳本來自動化整個抓取和下載過程,甚至可以設置計畫任務來定期運行。

如何處理加密或受保護的PDF文件?

對於加密或受保護的PDF文件,你可能需要先解密或破解密碼。PyPDF2提供了一些基本的解密功能,但請注意遵循法律和道德規範。

是否有適合初學者的教學資源?

有很多免費的Python教學資源可以幫助初學者學習如何抓取和處理PDF文件,比如官方的Python文檔、在線課程以及社區論壇。

總結

抓取和處理PDF文件可能看似複雜,但有了Python這些強大的工具和庫,這一切都變得輕而易舉。無論你是為了工作還是個人興趣,學會這些技能將讓你在數據處理的道路上如虎添翼。希望這篇文章能夠幫助你開啟PDF抓取的新世界!